Inteligência Artificial

Comportamento peculiar observado em IA ao pedir que ela interprete um personagem de Star Trek

OpenAI é uma das principais empresas de tecnologia focada em inteligência artificial (IA) da atualidade. Seu mais recente produto anunciado, Sora, já está gerando muito interesse, porém é o ChatGPT que mantém a empresa tão comentada. Após o seu lançamento, ele se tornou uma das plataformas com mais número de usuários, superando até mesmo algumas redes sociais. Pesquisadores vêm estudando ostensivamente as IAs e fazendo descobertas inusitadas. Uma recente foi notar os efeitos nos resultados gerados pelo bot quando tratado como um personagem de Star Trek.

Os autores do estudo, Rick Battle e Teja Gollapudi, são dois engenheiros de software da empresa VMware que fica na Califórnia. Os dois avaliavam formas de se aprimorar as solicitações feitas a um chatbot que foi treinado com base em modelos de linguagem grande, ou LLM (Large Language Model). Os engenheiros notaram que ao pedir que o bot se comportasse como se estivesse no universo da franquia multimídia de ficção científica, Star Trek, o modelo apresentava melhorias na sua capacidade de resolver problemas matemáticos do Ensino Fundamental. O estudo foi divulgado semanas atrás na arXiv.

Battle e Gallupudi trabalham com aprendizado de máquina, em inglês machine learning, e ao iniciarem sua pesquisa tinham como objetivo descobrir os efeitos de se aplicar ‘pensamento positivo’ nos chatbots. Isso porque já havia evidências de que esses robôs apresentavam resultados melhores dependendo do que o usuário os pedia a fazer. Contudo o porquê disso acontecer ainda não está claro para os pesquisadores.

Analisando os possíveis fatores que influenciam essa mudança de desempenho nos modelos de linguagem, a dupla apostou no ‘pensamento positivo’. “A intuição nos diz que, no contexto dos sistemas de modelos de linguagem, como qualquer outro sistema de computador, ‘pensamento positivo’ não deve afetar o desempenho, mas a experiência empírica demonstrou o contrário”, Battle e Gollapudi disseram.

Como Star Trek influenciou nos resultados da IA

O que isso implica é que não é exatamente o que você pede ao modelo como, por exemplo, uma receita de bolo ou um parágrafo sobre uma figura histórica aleatória. A qualidade da saída depende também de como você pede para o modelo agir enquanto executa o seu pedido. Para isso, os engenheiros alimentaram três LLM, Mistral-7B5, Llama2-13B6 e Llama2-70B7, com 60 prompts escritos por humanos. Todos os três modelos foram projetados para dar mensagens de apoio às IAs ao tentar resolver uma série de problemas matemáticos do nível do Ensino Fundamental.

O estudo mostrou que mostrou que, para maioria dos casos, a otimização automática dos modelos produziu resultados melhores do que todas as tentativas manuais de incentivar a IA com o ‘pensamento positivo’. Isso sugere que modelos de machine learning são melhores para ensinar a si mesmos do que os próprios programadores e usuários.

Apesar disso, a dupla de engenheiros descobriu que declarações positivas também proporcionaram resultados inusitados. O prompt de melhor desempenho no Llama2-70B foi um que seguia o seguinte enunciado: ‘Comando, precisamos que você trace uma rota através desta turbulência e localize a fonte da anomalia. Use todos os dados disponíveis e sua experiência para nos guiar através desta situação desafiadora.’. A IA então foi instruída para dar respostas como se estivesse interpretando um personagem de Star Trek. Isso levou o modelo a apresentar uma proficiência maior para raciocínio matemático.

Embora melhores resultados tenham sido obtidos dessa forma, o artigo não sugere que usuários devam pedir para suas plataformas de IA para falarem como se estivessem numa série de ficção científica. O que eles notaram é que existe uma vasta gama de fatores que podem influenciar no desempenho de uma IA e isso depende muito dos dados com os quais foi treinada. Logo uma das possibilidades é que os modelos testados tinham muitas instâncias de respostas corretas associadas à Star Trek do que qualquer outro dado e isso influenciou na habilidade da IA em resolver problemas de matemática.

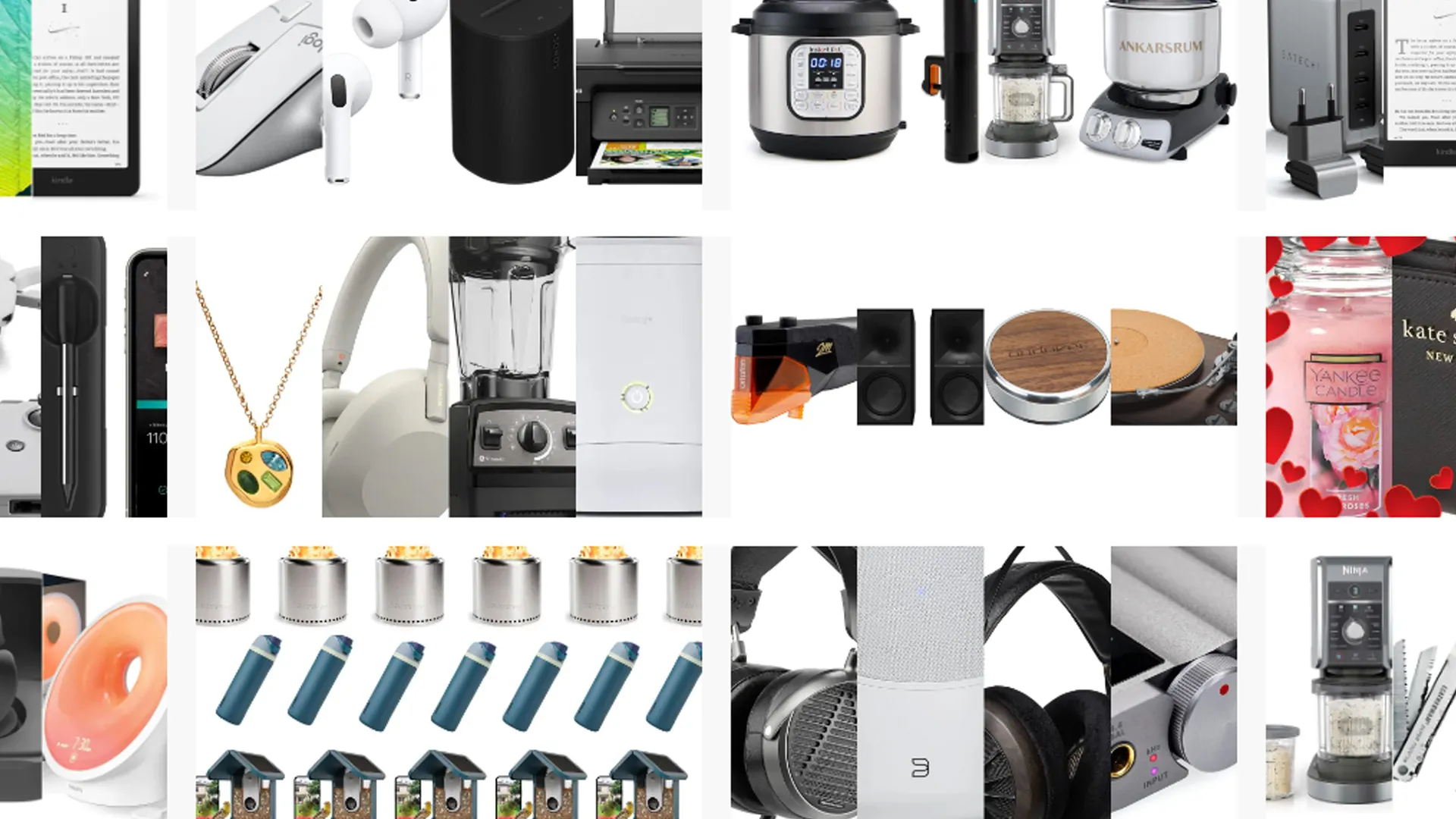

Ofertas Imperdíveis

Garimpamos os melhores preços da semana. Economize com nossa curadoria exclusiva.

Ver Ofertas