Tecnologia

A inteligência artificial não é uma ameaça — ainda

A inteligência artificial como uma ameaça à existência.

Em 2014, o CEO da SpaceX Elon Musk twittou: “Vale a leitura de Superinteligência de Bostrom. Precisamos ser supercuidadosos com a Inteligência Artificial (IA). Potencialmente mais perigosa do que as armas nucleares”. Naquele mesmo ano Stephen Hawking da universidade de Cambridge disse à BBC: “O desenvolvimento da inteligência artificial completa pode significar o fim da raça humana”. Bill Gates, cofundador da Microsoft, advertiu também: “Eu estou preocupado com a superinteligência”.

O apocalipse que a IA pode desenrolar foi esboçado pelo cientista da computação Eliezer Yudkowsky em um artigo de 2008 no livro “Global Catastrophic Risks”: “Quão provável é que a IA atravesse toda a vasta lacuna entre a ameba e o idiota da aldeia, e então pare ao nível do gênio humano?” Sua resposta: “Seria fisicamente possível construir um cérebro que calculasse um milhão de vezes mais rápido que um cérebro humano… Se uma mente humana fosse assim acelerada, um ano subjetivo de pensamento seria realizado para cada 31 segundos físicos no mundo exterior e um milênio passaria em oito horas e meia”. Yudkowsky acha que se não chegarmos ao topo disso agora será tarde demais: “A IA funciona em um tempo diferente do seu; pelo tempo que seus neurônios demoram para pensar as palavras ‘eu deveria fazer algo’ você já perdeu”.

Um exemplo paradigmático é o experimento mental do filósofo Nick Bostrom, da Universidade de Oxford, o chamado maximizador do clipe de papel apresentado em seu livro Superintelligence: uma IA é projetado para fazer clipes de papel e, depois de passar por seu suprimento inicial de matérias-primas, ela utiliza quaisquer átomos disponíveis que estejam dentro do seu alcance, incluindo os seres humanos. Como ele descreveu em um artigo de 2003, a partir daí ela “começa a transformar primeiro toda a terra e, em seguida, aumentar as porções de espaço disponível em instalações de fabricação de clipe de papel.” Em pouco tempo, todo o universo é composto de clipes e de fazedores de clipes.

Sejamos um pouco mais céticos. Em primeiro lugar, todos os cenários do dia do julgamento final envolvem uma longa sequência de contingências do tipo “se, então”. Caso haja uma falha em qualquer ponto, o apocalipse da Inteligência Artificial estaria negado. O professor de engenharia elétrica Alan Winfield, da University of West England Bristol, explicou em um artigo de 2014: “Se conseguirmos construir uma IA equivalente à inteligência humana e se essa IA adquiri uma compreensão completa de como ela funciona e se ela conseguir melhorar a si mesma para produzir inteligência artificial superinteligente, e se esse super-IA, acidentalmente ou maliciosamente, começa a consumir recursos, e se não conseguimos puxar o plug da tomada, então, sim, podemos muito bem ter um problema. O risco, embora não impossível, é improvável”.

Em segundo lugar, o desenvolvimento da IA tem sido muito mais lento do que o previsto, permitindo que com o tempo extra se possa construir etapas de checagem em cada fase. Como disse o presidente executivo do Google, Eric Schmidt, em resposta a Musk e Hawking: “Você não acha que os humanos notariam isso acontecendo? E você não acha que os seres humanos iriam então desativar esses computadores? “O próprio DeepMind, do Google, desenvolveu o conceito de um interruptor de desligamento de IA, descrito brincando como “um grande botão vermelho” para ser usado no caso de uma tentativa de aquisição de IA. Como o vice-presidente do Baidu, Andrew Ng, colocou (em um jab em Musk), seria “como se preocupar com a superpopulação em Marte, quando ainda nem sequer pusemos o pé no planeta”.

Em terceiro lugar, os cenários apocalípticos quem envolvem a IA são frequentemente baseados em uma falsa analogia entre inteligência natural e inteligência artificial. Como o psicólogo experimental Steven Pinker da universidade de Harvard elucidou em sua resposta no Debate Anual 2015 do Edge.org “O que você pensa sobre máquinas que pensam?”: “As distopias da IA projetam uma psicologia provinciana do alfa-macho no conceito da inteligência. Eles supõem que os robôs super-humanente inteligentes desenvolveriam objetivos como depor seus mestres ou tomar o mundo.” É igualmente possível, Pinker sugere, que “a inteligência artificial evoluirá naturalmente ao longo das linhas fêmeas: inteiramente capaz de resolver problemas, mas sem o desejo de aniquilar inocentes ou dominar a civilização”.

Em quarto lugar, a implicação de que os computadores “querem” fazer alguma coisa (como converter o mundo em clipes) significa que AI tem emoções, mas como observa o escritor de ciência Michael Chorost “a partir do minuto que uma IA quer algo, ela viverá em um universo com recompensas e castigos – incluindo castigos nossos por se comportar mal”.

Dada a taxa de sucesso histórico de zero por cento de previsões apocalípticas, juntamente com o desenvolvimento gradualmente gradual da IA ao longo das décadas, temos tempo de sobra para construir sistemas de segurança contra falhas para evitar qualquer apocalipse da tal IA.

De Michael Shermer para a Scientific American em 01º de março de 2017. Este artigo foi publicado originalmente com o título “Apocalypse AI”

Sobre o autor:

Michael Brant Shermer (Glendale, 8 de setembro de 1954) é um psicólogo, escritor e historiador da ciência estadunidense, fundador e editor da revista Skeptic Magazine (www.skeptic.com) e diretor da Skeptics Society. É também colunista da Scientific American. Shermer escreveu o livro O Arco Moral (Henry Holt, 2015), que foi publicado na em versão livro de bolso.

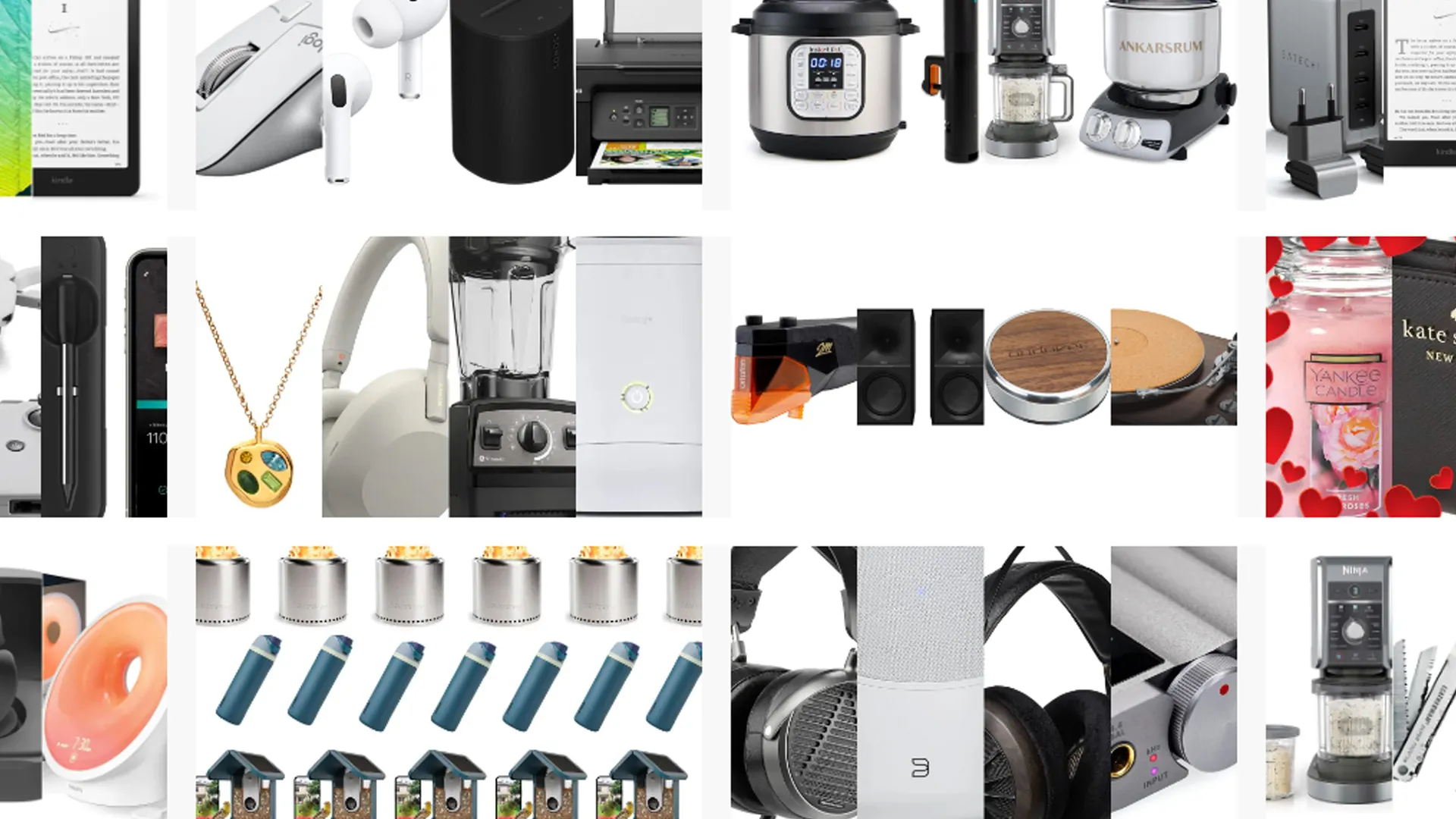

Ofertas Imperdíveis

Garimpamos os melhores preços da semana. Economize com nossa curadoria exclusiva.

Ver Ofertas