Inteligência Artificial

Teste simples revela por que Inteligência Artificial ainda não consegue raciocinar como humanos

Em um experimento simples, até bobo, a Inteligência Artificial não se saiu bem. Ele consiste em um tomate e uma cenoura, ambos lavados, que são colocados sobre um prato de cozinha comum. Ao virar o prato de cabeça para baixo, sem qualquer suporte para os alimentos, é natural que ambos caiam no chão. A conclusão é imediata e evidente, baseada nas leis da gravidade e no comportamento esperado de objetos soltos quando submetidos a essa condição.

Não é necessário realizar o experimento para prever o resultado, pois o desfecho é intuitivo. A simplicidade do cenário revela uma antecipação quase automática do que aconteceria, evidenciando como o raciocínio humano lida facilmente com situações físicas corriqueiras.

No entanto, os grandes modelos de linguagem, também chamados de LLMs, costumam errar esse teste simples. Modelos como o GPT-4o e o Claude 3.5 Sonnet frequentemente cometem erros nesta questão, geralmente optando pelas alternativas B ou C. Esse padrão de erro também pode ser observado em outras famílias de modelos, como o Llama 3.1 e o Google Gemini, que tendem a falhar da mesma forma.

“Totalidade da IA”

Alguns especialistas afirmam que esses modelos — ou até suas versões anteriores — já alcançaram o status de inteligência artificial geral. Segundo essas análises, eles colocam em risco centenas de milhões de empregos.

O Goldman Sachs, por exemplo, alerta sobre esse impacto, enquanto o Fundo Monetário Internacional sugere que até 40% dos empregos em economias avançadas podem ser afetados.

Além disso, muitos avisos apontam para a ameaça de que a IA represente para a continuidade da humanidade. Isso não significa que esses alertas estejam incorretos, ou que os modelos de linguagem representem toda a amplitude da Inteligência Artificial. A intenção é destacar o quão surpreendente pode ser descobrir que os chamados “modelos de ponta” ainda falham em questões bastante simples.

Falha de raciocínio espacial

Embora muito bem desenvolvidos, por que esses modelos de linguagem erram testes tão simples como o mencionado? Philip L, criador do canal AI Explained no YouTube e administrador do AI Insiders, uma comunidade de mais de 1.000 profissionais trabalhando em IA generativa em 30 setores, tem desenvolvido um projeto chamado “Banco Simples” ou “Simple Bench”.

No Banco Simples é possível verificar o desempenho atual dos principais modelos, testar algumas questões por conta própria e entender melhor o projeto. A maior parte das perguntas é privada para evitar que os modelos memorizem respostas, como se suspeitassem que foram feitas em outros testes de benchmark populares.

A questão do experimento com vegetais é um exemplo de falha de cálculo espacial, em que os modelos não compreendem que objetos cairão de um prato se não forem seguros. Outras falhas incluem análise temporal, onde os modelos têm dificuldades em estimar o tempo necessário para ações, e inteligência social, que envolvem a habilidade de prever comportamentos humanos básicos.

Desse modo, o Banco Simples não se concentra apenas em erros ocasionais, que poderiam ser corrigidos com ajustes. Também não é sobre questões de tokenização, como contar letras em palavras, ou erros matemáticos que envolvem cálculos complexos.

A ideia é destacar um tipo de esclarecimento que pessoas comuns acertariam facilmente, mas que ainda confunde muitos modelos de linguagem. A diferença de desempenho entre humanos e esses modelos no Banco Simples é bem maior do que o que se pode imaginar a partir de manchetes sobre inteligência artificial.

Os LLMs não modelam a realidade

Modelos de linguagem não permitem simular ou “visualizar” cenários como fazemos. Eles facilmente se concentram em detalhes secundários e não têm um mecanismo para identificar o que é mais importante em uma situação.

Esses modelos lidam com a linguagem, não com a realidade. Seu foco é prever a próxima palavra, e não antecipar a sequência lógica de eventos. Como a linguagem reflete muitos aspectos da realidade e do conhecimento científico, modelos de linguagem podem se sair bem em testes que envolvem fatos conhecidos.

Contudo, quando enfrentam situações fora dessa zona de conforto, onde a linguagem não oferece um guia direto, eles falham frequentemente de maneira previsível.

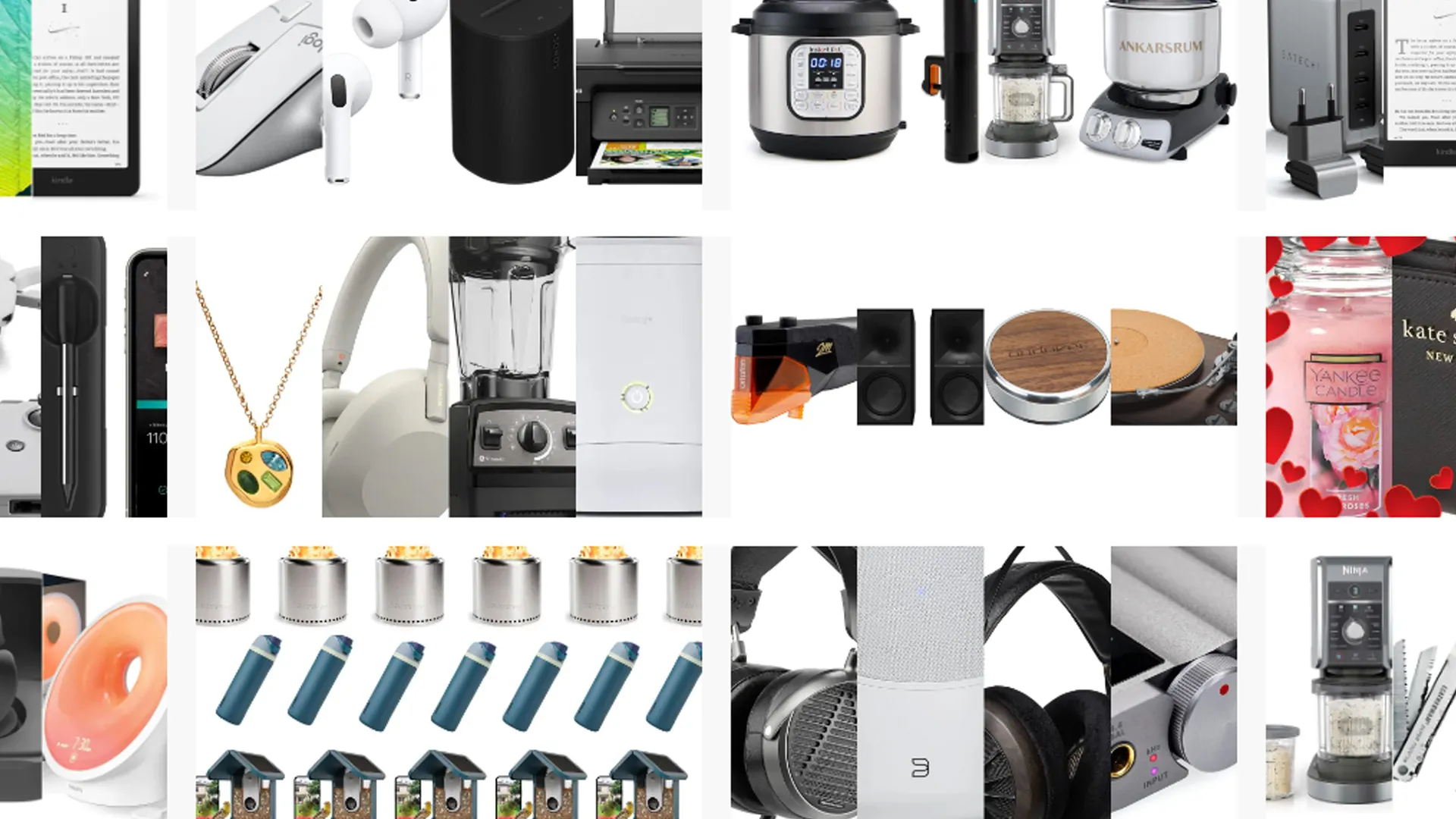

Ofertas Imperdíveis

Garimpamos os melhores preços da semana. Economize com nossa curadoria exclusiva.

Ver Ofertas