Tecnologia

IA pode criar propagandas tão assustadoras e persuasivas quanto as pessoas

Um novo estudo realizado por pesquisadores da Universidade de Stanford e da Universidade de Georgetown aponta a capacidade inquietante da propaganda gerada por IA de influenciar a opinião pública de forma quase tão eficaz quanto o conteúdo criado por humanos.

Em um experimento, o estudo que foi publicado recentemente na revista PNAS Nexus apresentou uma série de propagandas reais e criadas por IA sobre assuntos políticos acalorados a mais de 8.000 destinatários americanos. Os resultados mostraram que o poder de persuasão não diferiu significativamente; o conteúdo gerado por IA ficou atrás da eficácia humana por apenas quatro pontos percentuais.

Um sistema de IA específico conhecido como GPT-3, o precursor do ChatGPT, foi o mecanismo por trás desse experimento. Ele precisou de apenas algumas amostras de propaganda existentes para aprender e gerar novos artigos que pudessem se misturar perfeitamente com a desinformação criada por humanos. O estudo revelou como intervenções humanas modestas poderiam aprimorar ainda mais a natureza convincente da IA. A revisão e a seleção dos artigos mais convincentes de autoria da IA, ou mesmo o ajuste fino das instruções dadas à IA, resultaram em maior capacidade de persuasão.

As preocupações aumentam quando se considera a variedade de conteúdo que a IA pode potencialmente produzir, que não se limita apenas a artigos de texto. Publicações em mídias sociais, comentários e até mesmo multimídia, como áudio ou vídeo, apresentam o risco de serem fabricados com igual convicção.

Josh Goldstein, da Universidade de Georgetown, liderou o estudo que esclareceu esse potencial desconcertante. A equipe enfatizou a necessidade de desenvolver sistemas de detecção robustos como uma contramedida para essas campanhas de desinformação difundidas por IA. A descoberta de contas falsas e a identificação do maquinário que dissemina essas narrativas são etapas fundamentais para mitigar os riscos.

Aprimorar nossa defesa contra a propaganda habilitada por IA significa focar não apenas no conteúdo, mas também nas redes de distribuição – como contas de mídia social não autênticas – usadas para atingir públicos-alvo. A escalabilidade das ferramentas de IA na geração de conteúdo de propaganda exige uma escala equivalente nos esforços de pesquisa para destacar e desmantelar a infraestrutura propulsora dessas narrativas falsificadas.

Com a IA, até mesmo indivíduos ou pequenos grupos sem proficiência em idiomas podem gerar facilmente volumes de conteúdo alinhado à narrativa, cada um variando sutilmente em estilo e redação. Isso não apenas multiplica o conteúdo, mas complica a capacidade de detecção, exigindo avanços na contraestratégia talvez ainda mais do que antes.

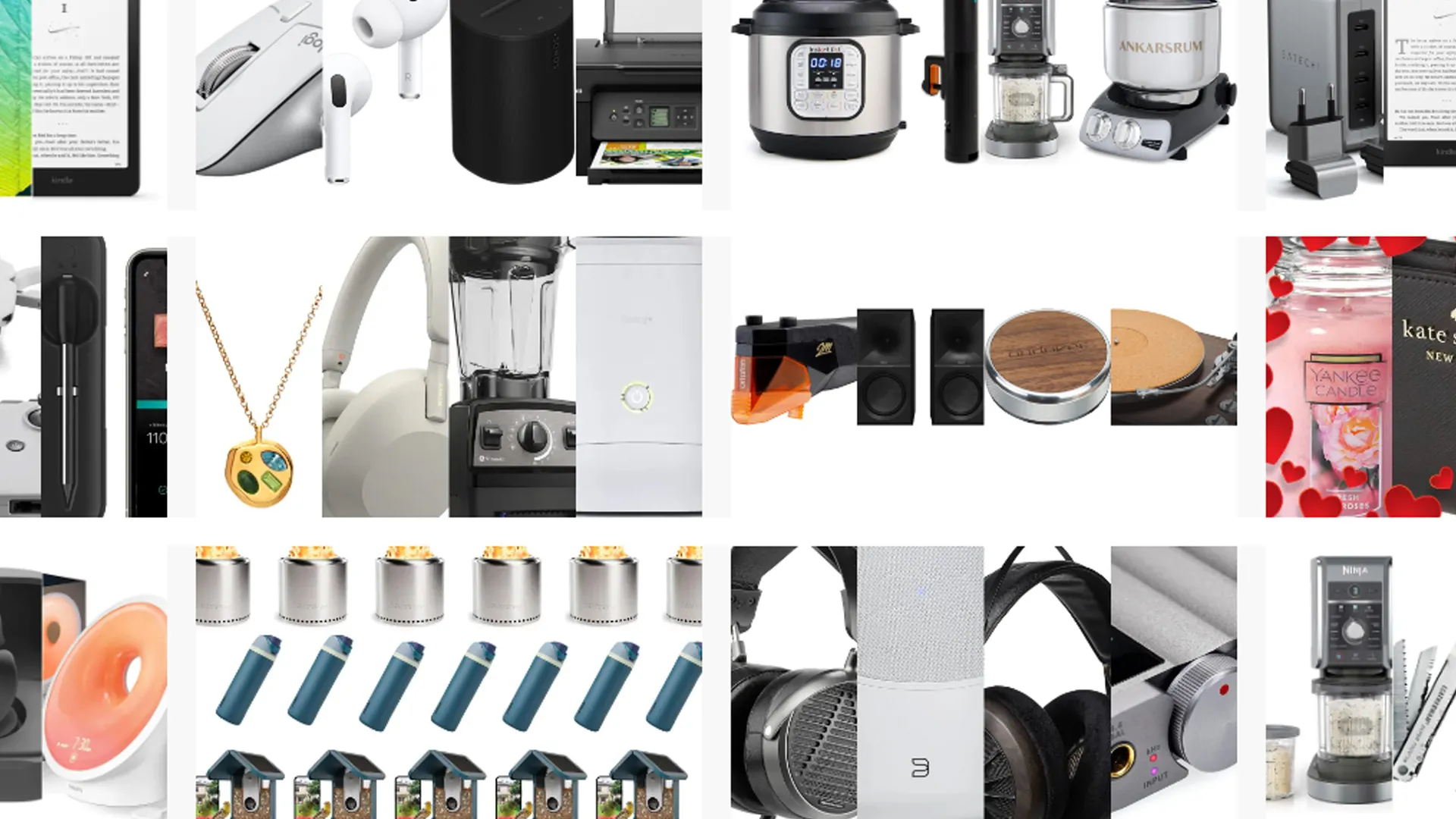

Ofertas Imperdíveis

Garimpamos os melhores preços da semana. Economize com nossa curadoria exclusiva.

Ver Ofertas