Tecnologia

A inteligência artificial pode imitar o cérebro?

Inteligências artificiais são excelentes ferramentas para a análise de dados, mas ainda há problemas.

Inteligências artificiais são excelentes ferramentas para a análise de dados. Elas são muito mais rápidas do que os humanos. No entanto, precisamos tomar muito cuidado com os dados que são inseridos nelas, já que eles podem utilizar tais dados de maneiras não previstas. Ficou famoso o caso da COMPAS, uma inteligência artificial que trouxe um viés racista às suas leituras.

Como funcionam as inteligências artificiais?

Para entender melhor o caso, precisamos antes entender os princípios básicos de funcionamento do machine learning. As IAs tradicionais funcionam da seguinte maneira: você seleciona uma série de dados e a deixa os analisar. Então, você diz a ela que tipo de resultado quer desses dados e a deixa aprender.

Por exemplo, você cria uma IA e insere uma série de imagens de formas geométricas – círculos, quadrados e triângulos. Então, você pede para ela encontrar alguma semelhança entre as imagens catalogá-las em três pastas, uma para cada uma das formas. No entanto, todos os quadrados, acidentalmente, eram azuis. E, então, ela aprendeu que todos quadrados eram azuis, e passaram a catalogar essas imagens dessa forma, e junto com os quadrados, a IA adicionou círculos e triângulos azuis, pois ela não tratou os dados da maneira prevista, já que os dados estavam enviesados e ela utilizou uma filtragem superficial em demasia. Obviamente esse é um exemplo muito simplista, mas já serve para explicar a problemática no machine learning.

AS IAs tendem a pegar atalhos, e isso faz com que dados enviesados causem resultados enviesados. A COMPAS foi um problema porque seu trabalho era analisar o risco de reincidência criminal. No entanto, o mundo ocidental é extremamente racista, e como a possibilidade de condenação de negros é maior, a IA entendeu que negros possuíam maiores chances de reincidir crimes, ao invés de encontrar um padrão realmente válido para a saída de dados.

O cientista da computação Alexei Efros, da Universidade da California, disse à revista Quanta Magazine que “estamos criando uma geração de algoritmos que são como graduandos [que] não assistiram as aulas durante todo o semestre e, na noite anterior à prova, estão estudando. Eles não aprendem o conteúdo de verdade, mas se saem bem na prova”.

Mas e se os vieses morais humanos não forem adicionados às inteligências artificiais?

Algumas inteligências artificiais são mais complexas do que o machine learning tradicional. Estas são as redes neurais. Elas levam esse nome por se inspirar na maneira como o cérebro humano trabalha.

Em um artigo publicado em 2017, um grupo de pesquisadores relatou uma inteligência artificial interessante. Sabe aquele ditado “errando é que se aprende?”. Pois bem, essa inteligência artificial, utilizava seus erros para incrementar suas conexões e diminuir sua taxa de erros. Esta não é a única inteligência artificial que faz isso. Na verdade, aprender com os erros é um dos princípios básicos do aprendizado de máquina atualmente.

Some à capacidade de reforçar suas “conexões neurais” à análise de dados sem rotulamento humano. Você tem o processamento de dados ideal. Um estudo publicado no final de 2021 descreve uma rede neural que mascarava dados para analisá-los. Ao tentar prever as partes mascaradas, ela reforçava suas conexões quando errava, aumentando sua taxa de acertos nas predições.

Por exemplo, ela mascarava uma foto de um ônibus, e tentava preencher a lacuna. Quando errava, aprendia com o erro e, erro vai erro vem, aprendeu a preencher a imagem de um ônibus. Isso é melhor do que você entregar à ela 10 mil imagens de um ônibus e ela saber o que é um ônibus por algum padrão que não esperássemos que ela levasse em conta.

Isso espanta, pois essas inteligências artificiais funcionam de maneira bastante semelhante ao cérebro humano, aprendendo da maneira que aprendemos, mas com a diferença de não ter os vieses morais que temos, caso seja exposta à dados limpos. Por isso é autosupervisionada, ou “autodidata”.

Isso abre caminho para inúmeras possibilidades para o processamento de dados. As IAs poderiam, por exemplo, encontrar padrões de reincidência criminal sem os vieses humanos, se fossem expostas a esses dados limpos e aprendessem como nós.

Mas obviamente ainda há problemas nas redes autosupervisionadas. O neurocientista Josh McDermott liderou um estudo em que sons horríveis à adição humana pareceram indistinguíveis de sinais reais de áudio para uma rede neural.

Portanto, ainda há muito trabalho a ser feito para que as redes neurais se aproximem de verdade ao funcionamento do cérebro humano. Mas esse ainda é um objetivo bastante distante para a ciência das inteligências artificiais

“Há muitas coisas a serem feitas para fazer algo semelhante ao que o cérebro faz”, relatou à Quanta Magazine o pesquisador Jean-Rémi King.

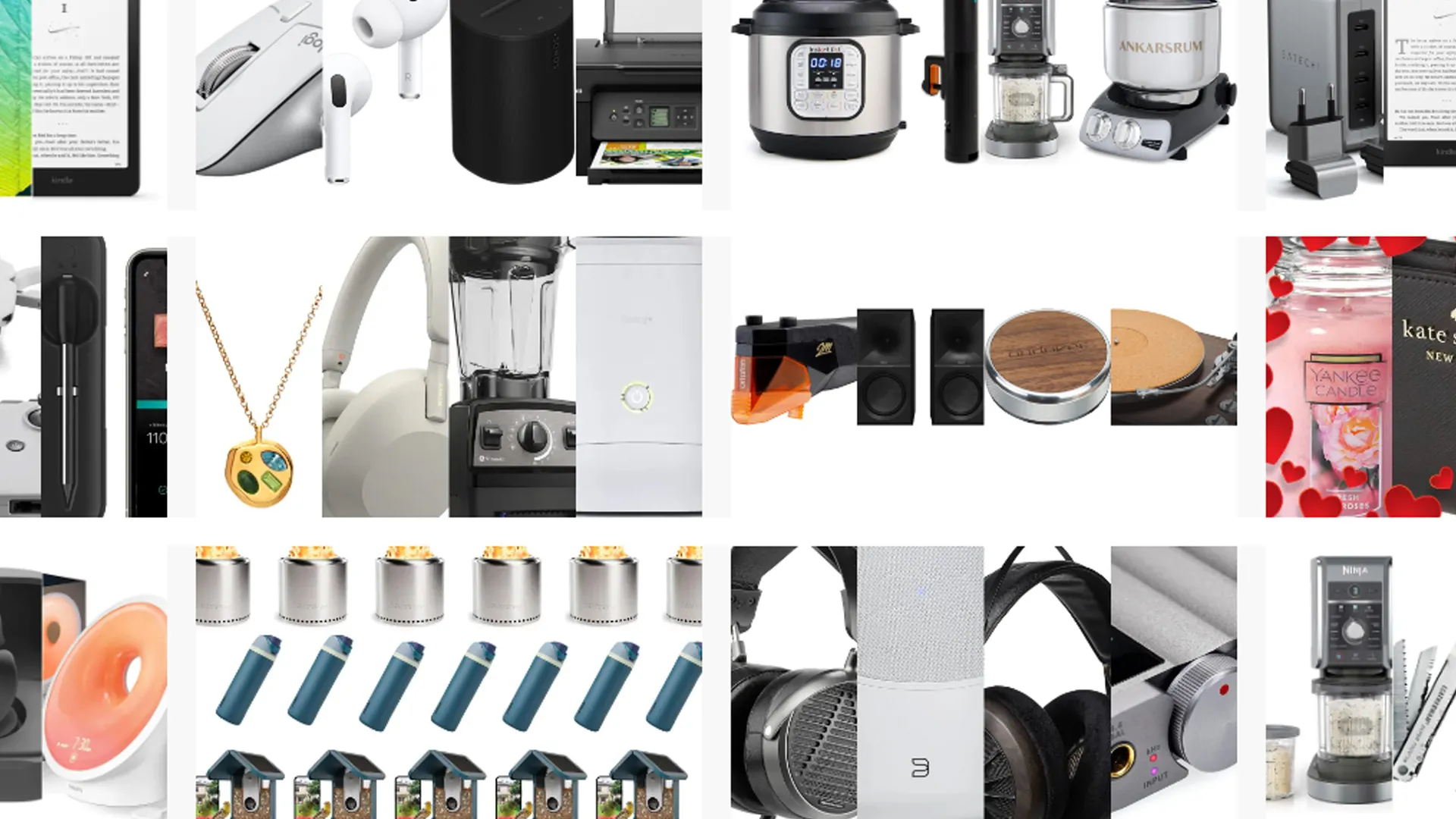

Ofertas Imperdíveis

Garimpamos os melhores preços da semana. Economize com nossa curadoria exclusiva.

Ver Ofertas